- OpenAI annonce un contrôle parental pour ChatGPT afin de protéger les adolescents.

- Les parents pourront lier leur compte et définir des règles de comportement du modèle.

- Des alertes seront envoyées en cas de détection de détresse aiguë chez l’enfant.

- Le contrôle parental fait partie d’une série de mesures visant à sécuriser les interactions avec l’IA.

OpenAI déploie un contrôle parental pour ChatGPT afin de sécuriser l’usage de l’intelligence artificielle par les enfants. Les parents pourront lier leur compte, recevoir des alertes et ajuster le comportement de l’IA pour prévenir tout risque ou exposition à des contenus dangereux.

OpenAI sécurise l’usage de ChatGPT

OpenAI a annoncé le lancement d’un mécanisme de contrôle parental pour l’intelligence artificielle ChatGPT, suite à des incidents préoccupants impliquant des adolescents. Le dispositif permettra aux parents de suivre les interactions, de paramétrer les réponses et de détecter tout signe de détresse chez leurs enfants. L’objectif est de concilier intelligence artificielle et sécurité des utilisateurs, en particulier des plus jeunes.

L’initiative marque un tournant dans l’adoption responsable de l’IA. Elle montre que les acteurs du numérique prennent conscience des risques liés à l’usage des agents conversationnels et souhaitent proposer des solutions concrètes pour limiter les conséquences potentiellement graves. Le contrôle parental s’inscrit dans une démarche proactive de protection, plutôt que de simple réaction à un incident.

Contrôle parental et fonctionnalités pour enfants

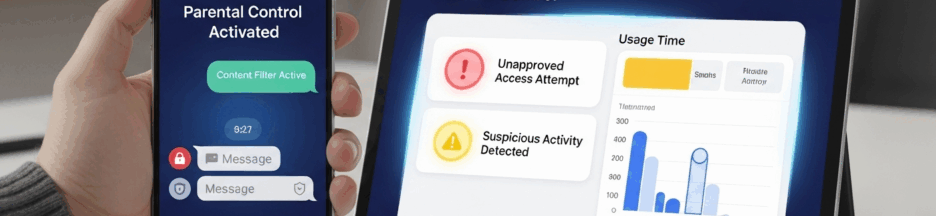

Les nouvelles fonctionnalités permettront aux parents de mieux encadrer l’utilisation de ChatGPT par leurs enfants :

- Lier leur compte à celui de l’adolescent, pour superviser l’ensemble des interactions et s’assurer que les échanges restent appropriés.

- Définir des règles de comportement du modèle, afin d’adapter les réponses de l’IA aux besoins et à la sensibilité de l’enfant.

- Recevoir des alertes en cas de détection de détresse aiguë, ce qui permet une intervention rapide et ciblée, contribuant à la protection émotionnelle des jeunes utilisateurs.

Ces outils constituent une première étape importante dans la sécurisation des interactions numériques. OpenAI prévoit d’étendre progressivement ces dispositifs dans les mois à venir, en redirigeant certaines conversations sensibles vers des modèles de raisonnement plus avancés, tels que GPT-5-thinking. Ces modèles appliquent plus strictement les consignes de sécurité et améliorent la détection des signaux de détresse, réduisant significativement les risques d’interactions problématiques pour les enfants et adolescents. Cette approche pourrait également servir de référence pour d’autres plateformes, renforçant l’ensemble du cadre de sécurité dans l’écosystème numérique destiné aux jeunes publics.

Analyse et enjeux de la protection des mineurs

La mise en place de ce contrôle parental illustre une responsabilisation accrue des acteurs de l’intelligence artificielle. Le recours à des modèles de raisonnement dédiés permet de mieux encadrer les conversations, tout en conservant l’expérience interactive qui fait la force de ChatGPT.

Ce dispositif pose également des questions éthiques et techniques : comment garantir que les modèles détectent efficacement les situations de détresse ? Quels mécanismes de sécurité peuvent prévenir l’exposition à des contenus sensibles ? Le contrôle parental se présente comme une première réponse, mais il devra évoluer pour faire face à des situations variées et imprévisibles, tout en respectant la confidentialité et l’autonomie des jeunes utilisateurs.

Tableau synthétique des fonctionnalités

| Fonctionnalité | Description | Objectif |

| Lien parent-enfant | Permet aux parents de suivre les interactions | Supervision sécurisée |

| Règles de comportement | Ajustement des réponses de ChatGPT selon l’âge et le profil | Adaptation aux besoins de l’enfant |

| Alertes de détresse | Notification immédiate en cas de danger | Intervention rapide |

| Redirection vers GPT-5-thinking | Conversations sensibles analysées par un modèle avancé | Sécurité renforcée |

Le tableau met en lumière la structure modulaire du contrôle parental, qui combine supervision, prévention et adaptation dynamique pour répondre aux besoins des jeunes utilisateurs.

Perspective sur l’IA et la sécurité des enfants

L’annonce d’OpenAI marque une étape importante dans l’histoire de l’intelligence artificielle et de la responsabilité numérique. Pour la première fois, les parents disposent d’outils concrets leur permettant de protéger leurs enfants tout en favorisant une utilisation réfléchie et constructive de l’IA. Cette initiative souligne à quel point il est crucial d’encadrer l’usage des technologies émergentes par des normes éthiques claires et des dispositifs de sécurité adaptés.

À l’avenir, il est très probable que d’autres plateformes et assistants conversationnels adoptent des dispositifs similaires, contribuant ainsi à renforcer la sécurité et la qualité des interactions numériques pour tous les publics, et en particulier pour les plus jeunes, souvent les plus vulnérables face aux risques en ligne. Cette tendance pourrait poser les bases d’une responsabilisation accrue des acteurs du numérique et d’une culture d’usage plus sécurisée et consciente des technologies.

Vers une IA plus sûre pour les jeunes

L’initiative d’OpenAI illustre l’importance d’une régulation proactive et d’outils de contrôle adaptés à la protection des enfants dans le monde numérique. En offrant aux parents la possibilité de superviser les interactions, de paramétrer le comportement de l’IA et de recevoir des alertes en cas de détresse, la plateforme ouvre la voie à une utilisation plus sécurisée et responsable de l’intelligence artificielle.

Découvrez sur la page Facebook de Mobifun toutes nos analyses et conseils pour utiliser l’intelligence artificielle en toute sécurité avec les enfants.